书接上回,我们已经讨论了OLS估计值的期望,接下来我们讨论其方差。

OLS估计量的方差

Var(β0^) , Var(β1^)

理解:我们每次估计的过程相当于从总体中抽取样本并对参数进行估计的过程,这个过程可以重复很多次,假设次数为 n ,我们对方差进行分析。

首先引人假定 SLR.5SLR.5 $ (Homoskedasticity \ \pmb{同方差性})$

Var(ui ∣ xi)=σ2

理解:等号右侧为常数,即不论x取何值,均不会对u的波动性(方差)造成影响

关于SLR.4 与 SLR.5 的区别与联系:

- 两者具有很大的区别,一个侧重期望,一个侧重方差。SLR.5 对于证明无偏性无作用,反之亦然。

- 两者均不能代表u与x独立,独立是一个过强的假定,由独立可以推导到SLR.4 与 SLR.5,但无法反推。

关于条件期望与方差的感性理解:

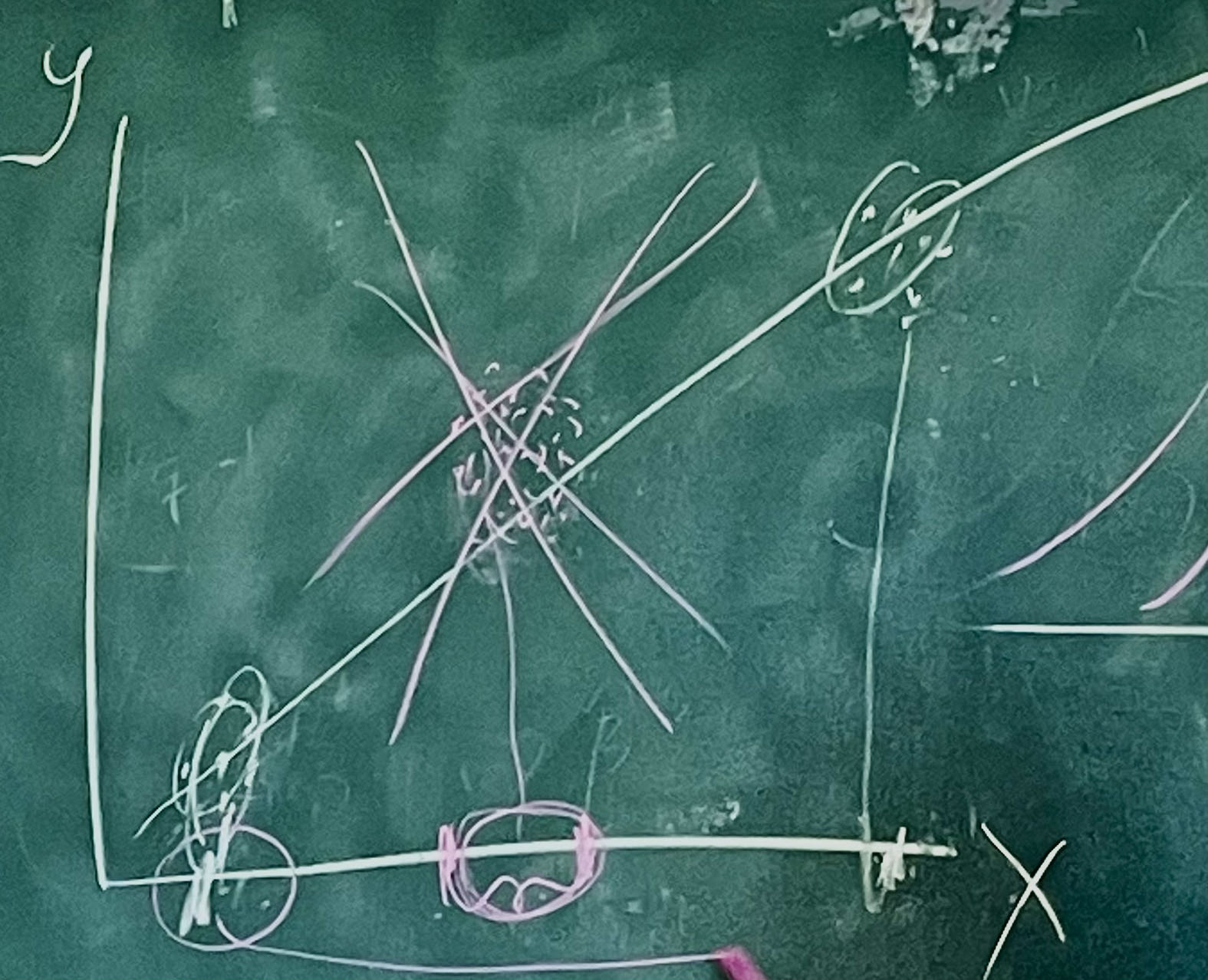

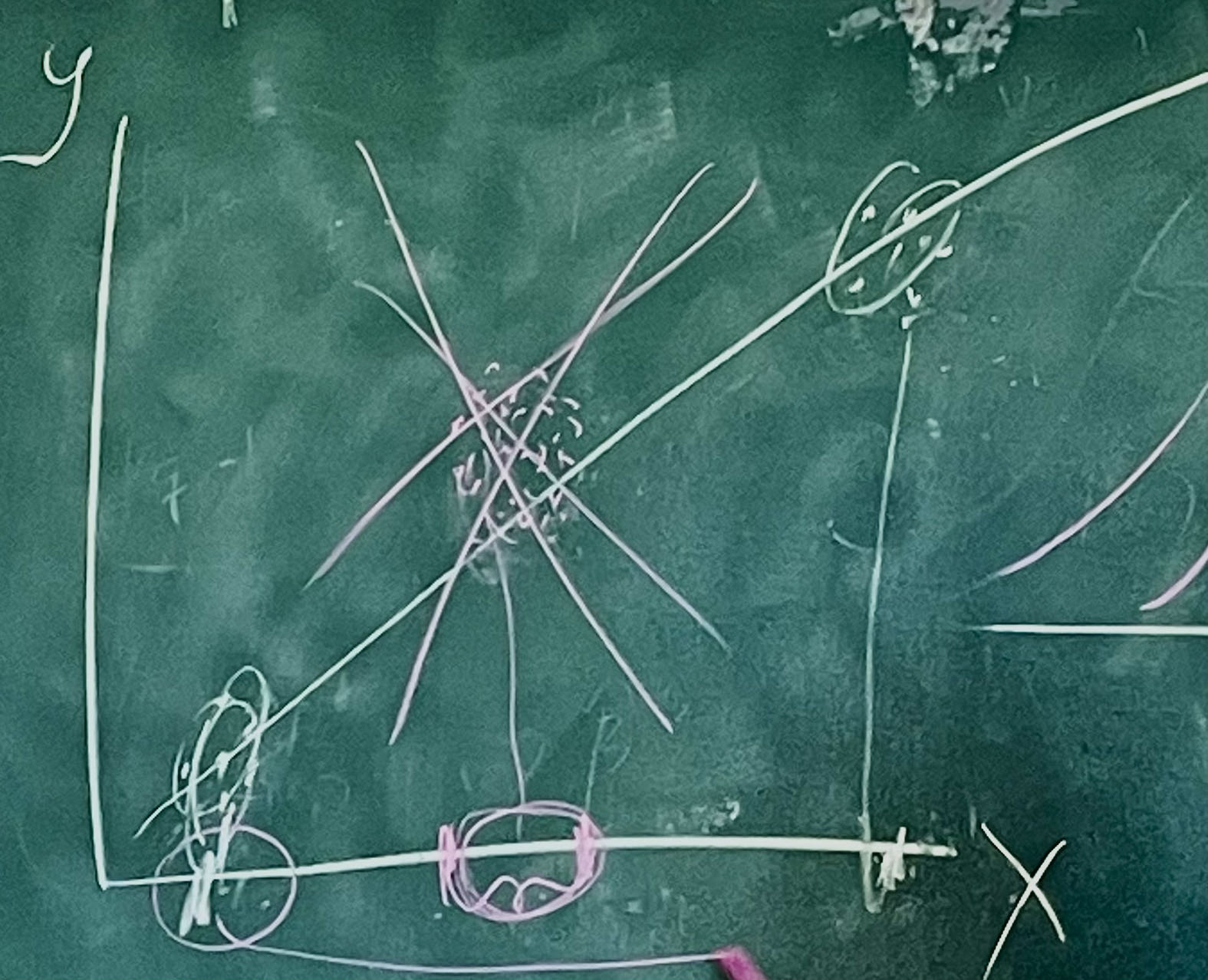

我们把真实世界中的 (xi,ui) 投影到坐标系中。每个固定的横坐标值都对应一串u,满足一定分布。同方差性意味着不同的横坐标值不会导致u的方差的变化(但u的分布可能会改变)。

我们继续讨论:

Var(yi ∣ xi)=Var(β0+β1xi+ui ∣ xi)=Var(ui ∣ xi)=σ2

即,当我们在讨论u的方差时,其实也就在讨论y的方差。

定理 2.2 OLS估计量的抽样方差

先给出结论:

Var(β1^)=∑i=1n(xi−xˉ)2σ2=SSTxσ2

Var(β0^)=n SSTxσ2∑i=1nxi2

直观来看,不可观察的误差项的方差越大,系数估计值得方差越大;自变量波动性越大,回归系数估计值的方差越小。

在社会科学中,很多时候,我们只能进行一次抽样。因此,我们希望回归系数估计值的方差尽可能小,即追求 min(Var(β1^)),因此,我们应当使 SSTx 尽可能大,即让x的波动性尽可能大。例如,在调查学历对工资的影响时,我们应当取尽可能大的学历跨度。

另一种理解:如果x跨度很小,那么在数据点拟合坐标轴上就会聚成一团,难以判断直线斜率。

定理 2.2 的证明

以样本 X 为条件,我们已知:

β1^=β1+∑i=1n(xi−xˉ)21i=1∑n(xi−xˉ)ui

于是:

Var(β1^)=Var(SSTx1i=1∑n(xi−xˉ)ui)=SSTx21i=1∑n(xi−xˉ)2Var(ui)

关于上式的变形,因为∑ 中每一项都不相关,故可以将Var分配进去,具体来说:

Var(i=1∑n(xi−xˉ)ui)

=Var( (x1−xˉ)u1+(x2−xˉ)u2+...+(xn−xˉ)un)

=Var((x1−xˉ)u1)+Var((x2−xˉ)u2)+...+Var((xn−xˉ)un)

=(x1−xˉ)2Var(u1)+(x2−xˉ)2Var(u2)+...+(xn−xˉ)2Var(un)

=i=1∑n(xi−xˉ)2Var(ui)

因为 Var(ui)=σ2 ,故:

Var(β1^)=SSTx21i=1∑n(xi−xˉ)2 σ2 =SSTx21SSTX σ2=SSTxσ2

误差方差σ2的估计

我们不知道σ2,故需要进行估计。

σ2^=n−21i=1∑nui^2=n−2SSR

这个式子从何而来?

首先,我们需要的是一个"估计量",即式子中的数据应当可以通过样本获得,故应使用ui^而非ui。其次,n−2 不是巧合,只有取n−2时才是一个无偏估计量,其原因在于:

关于最初的两个一阶约束条件:

n1i=1∑nui^=0i=1∑nui^xi=0

这两个约束条件导致了ui 并不能任意取值,OLS残差只有n−2个自由度

定理2.3 误差项方差估计值的无偏性

E(σ2^)=σ2

其中:

σ2^=n−21i=1∑nui^2

定理 2.3 的证明

ui^=yi−β0^−β1^xi=(β0+β1xi+ui)−β0^−β1^xi

ui^=ui−(β0^−β0)−(β1^−β1)xi(1)

n1i=1∑nui^=n1i=1∑n[ui−(β0^−β0)−(β1^−β1)xi]=0 (根据一阶约束条件)

所以:

uˉ−(β0^−β0)−(β1^−β1)xˉ=0(2)

(1)-(2)得到:

ui^=(ui−uˉ)−(β1^−β1)(xi−xˉ)

取平方:

ui^2=(ui−uˉ)2+(β1^−β1)2(xi−xˉ)2−2(ui−uˉ)(β1^−β1)(xi−xˉ)

再对各部分分别求和取期望,并对三部分分布分析:

第一部分:

E[ i=1∑n(ui−uˉ)2 ]=E[(n−1)∗样本方差]=(n−1)σ2

第二部分:

E[ i=1∑n(β1^−β1)2(xi−xˉ)2 ]=E[ i=1∑n(β1^−E[β1^])2(xi−xˉ)2 ]=E[Var(β1^)SSTx]=σ2

第三部分

E[ i=1∑n2(ui−uˉ)(β1^−β1)(xi−xˉ) ]=2(β1^−β1) E[ i=1∑n(ui−uˉ)(xi−xˉ) ]=2(β1^−β1) E[ i=1∑n[ui^+(β1^−β1)(xi−xˉ)](xi−xˉ) ]=2(β1^−β1)(E[i=1∑nui^(xi−xˉ)]+E[ i=1∑n(β1^−β1)(xi−xˉ)2 )=0+E[2(β1^−β1)2SSTx]=−2σ2

所以:

E(i=1∑nui^2)=(n−2)σ2E(n−21i=1∑nui^2)=σ2E(σ2^)=σ2

标准误(Standard Error)

标准误是估计方差的平方根,故随样本的变化而变化,衡量了回归系数估计的精确程度。

标准误是针对样本而言的,而方差和标准差是针对总体而言

se(β1^)=Var^(β1^)=SSTxσ^2

se(β0^)=Var^(β0^)=n SSTxσ^2∑i=1nxi2

再看假设

前面的若干假设其实意味着 ui 是独立同分布的,具体分布会在后文介绍。后续的研究会对假设进行削弱,如 ui 分布受 x 影响等。