条件期望

离散条件下的条件期望

在给定事件B(P(B)>0)的条件下,事件A发生的条件概率为

P(A∣B)=P(B)P(AB)

显然:

P(A∣B)=P(A) 当且仅当A,B相互独立

若P(B)>0,定义给定事件B的条件下,随机变量X的条件分布函数为:

FX(x∣B)=P(B)P(X≤x,B)

同样,在给定B的条件下,X的条件期望为:

E(X∣B)=P(B)E(XIB)

其中,IB 是示性函数:

IB(ω)={1,ω∈B0,ω∈/B

若X为离散型随机变量,则:

E[X∣B]=k=1∑∞xkP(B)P({x=xk}∩B)=k=1∑∞xkP(x=xk∣B)

若X为具有密度fX的随机变量,则:

E[X∣B]=P(B)1∫−∞∞xIB(x)fX(x) dx=P(B)1∫BxfX(x) dx

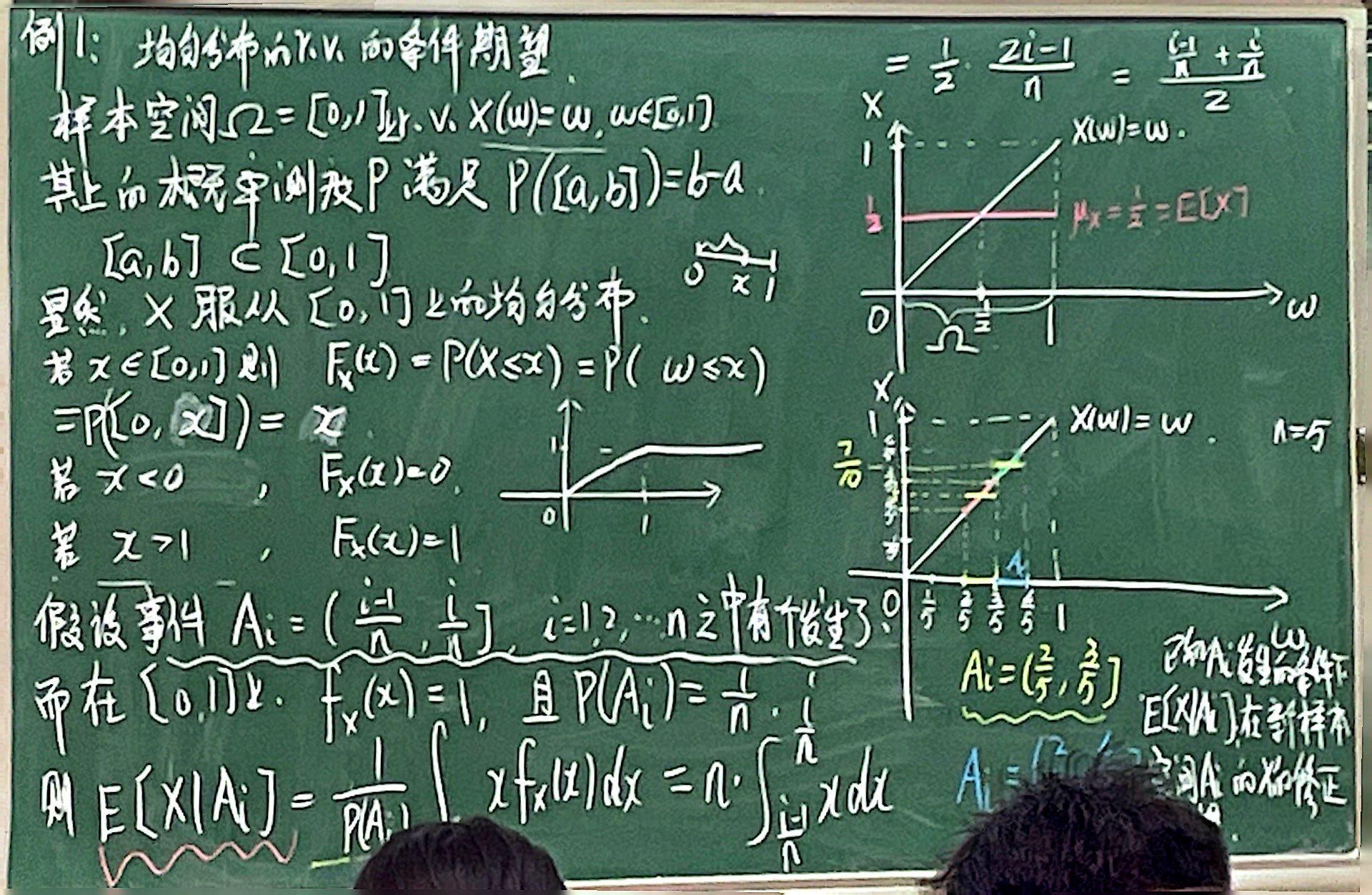

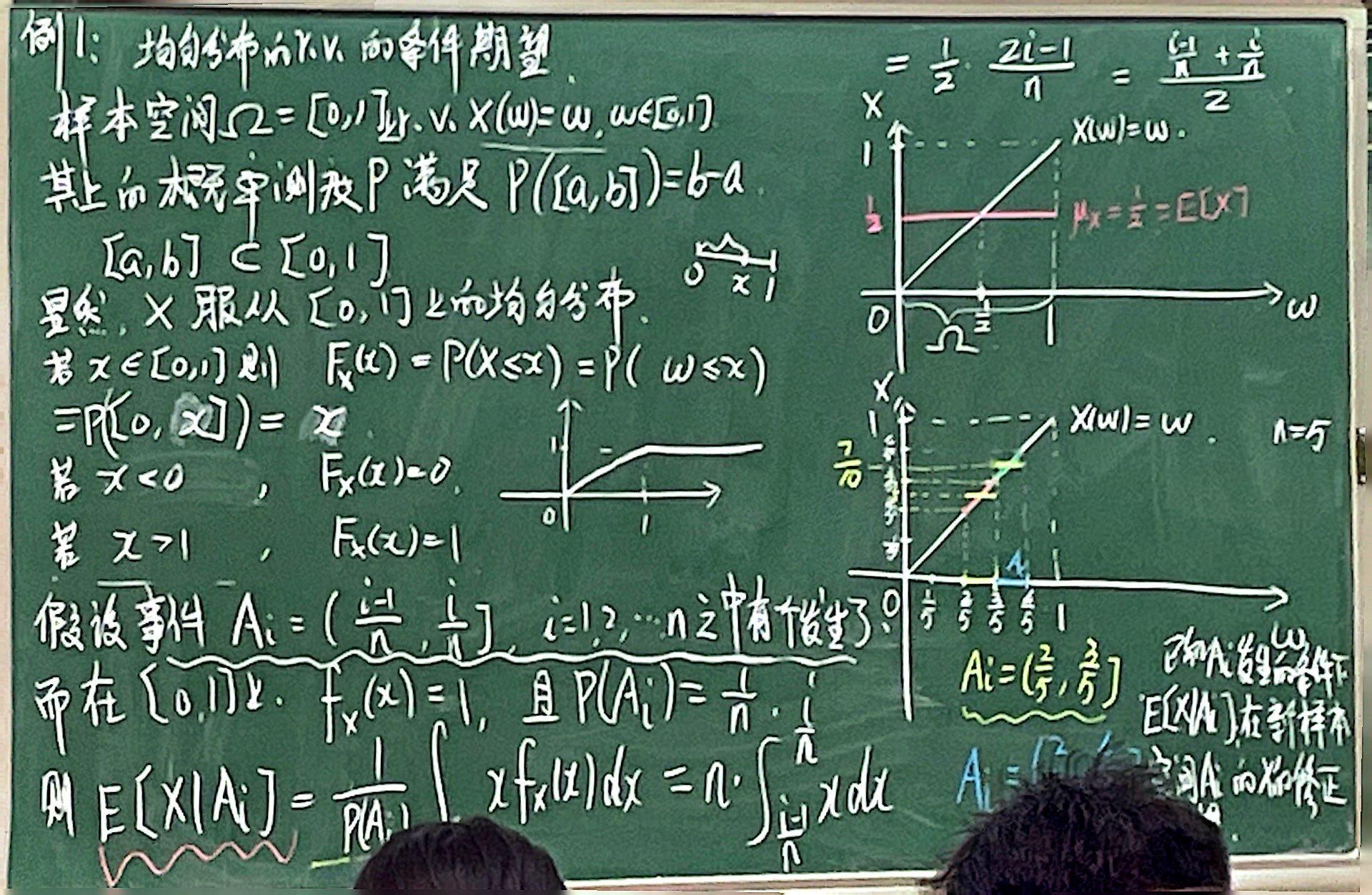

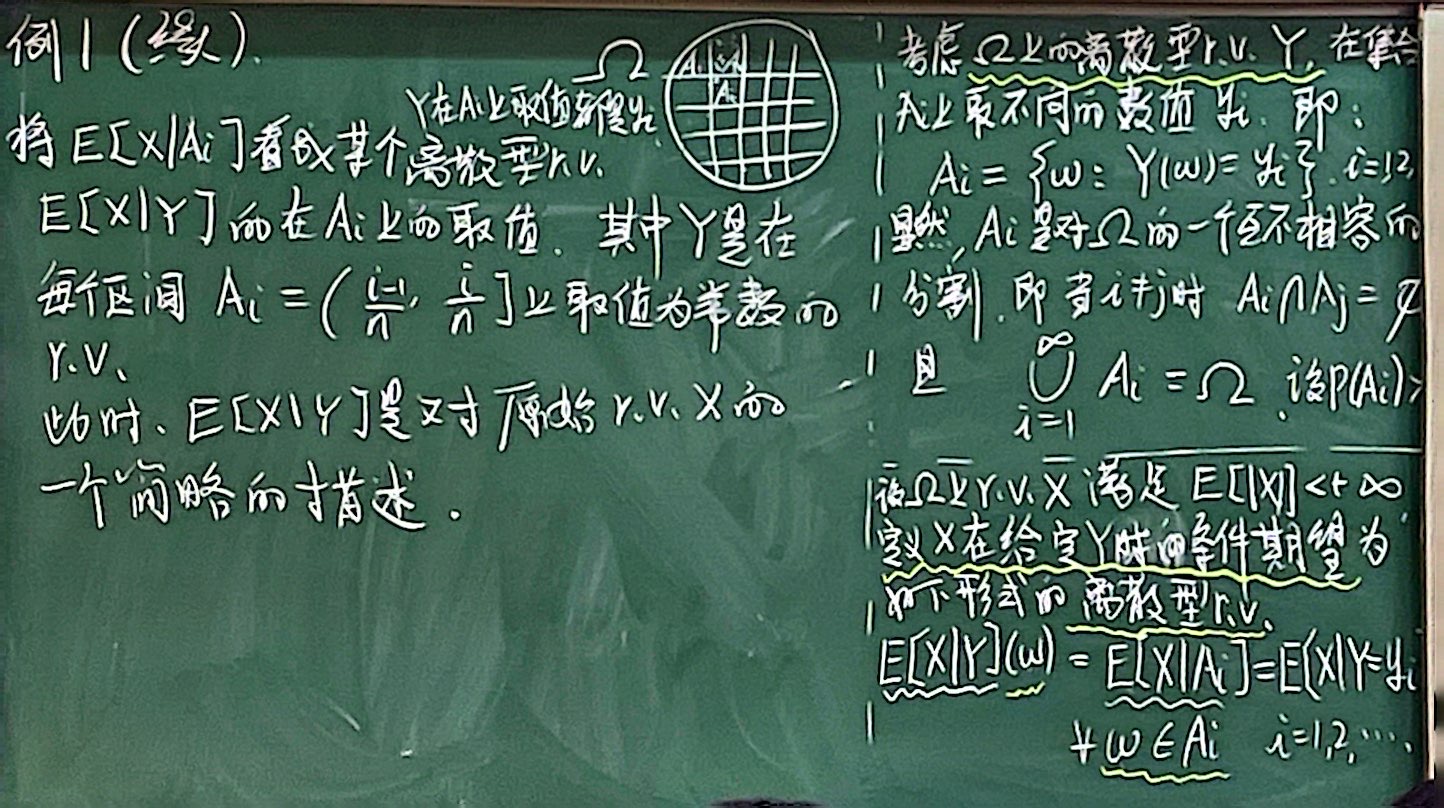

例1

均匀分布的随机变量的条件期望。样本空间Ω=[0,1],其上的概率测度P满足P([a,b])=b−a,显然,X服从[0,1]上的均匀分布

条件期望的性质

1、线性:

E[[C1X1+C2X2]∣Y]=C1E[X1∣Y]+C2E[X2∣Y]

2、重期望公式:

E[X]=E[E[X∣Y]]

整体的平均等于部分的平均再平均,其中部分平均E[X∣Y]是随机变量

证明:

E[E[X∣Y]]=i=1∑∞E[X∣Ai]P(Ai)=i=1∑∞P(Ai)E[XIAi]P(Ai)=i=1∑∞E[XIAi]=E[Xi=1∑∞IAi]=E[X]

注意,最后一步用到了:

i=1∑∞IAi=I∪i=1∞Ai=IΩ=1

3、如果X与Y独立,则

E[X∣Y]=E[X]

证明:

P(X∈A,Y=yi)=P(X∈A)P(Ai)

而

Ai={ω:IAi(ω)=1}={ω:Y(ω)=yi}

故:

P(X∈A,IAi=1)=P(X∈A)P(IAi=1)

同理将IAi=0代入也成立,故随机变量X与IAi也独立

E[X∣Y](ω)=E[X∣Ai]=P(Ai)E[XIAi]=P(Ai)E[X]E[IAi]=P(Ai)E[X]P(Ai)=E[X]

故:

E[X]=E[X∣Y]

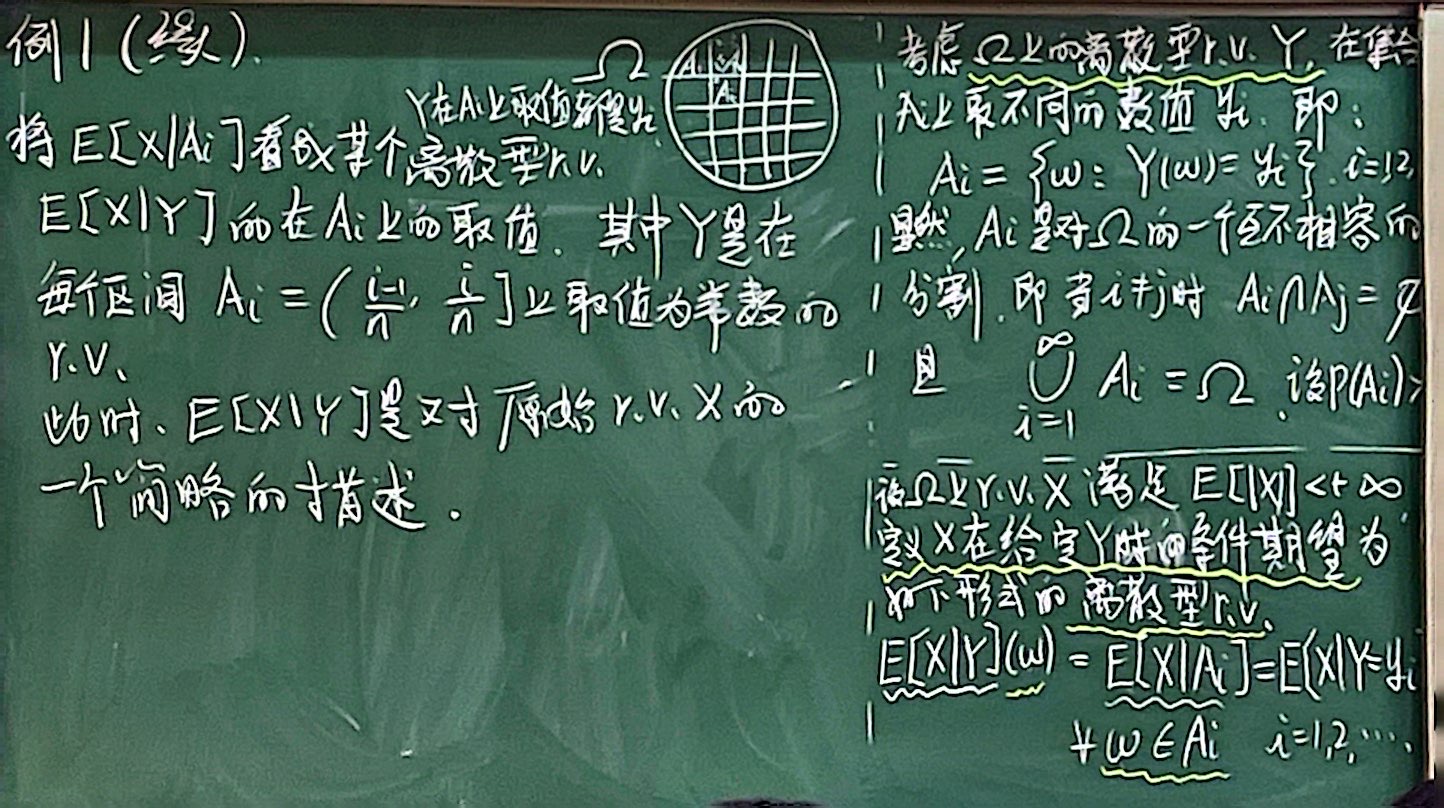

4、条件期望E[X∣Y]不是X的函数,而是Y的函数,随机变量X只是决定了这个函数的类型:

E[X∣Y]=g(Y)

其中:

g(y)=i=1∑∞E[X∣Y=yi] I{yi}(y)

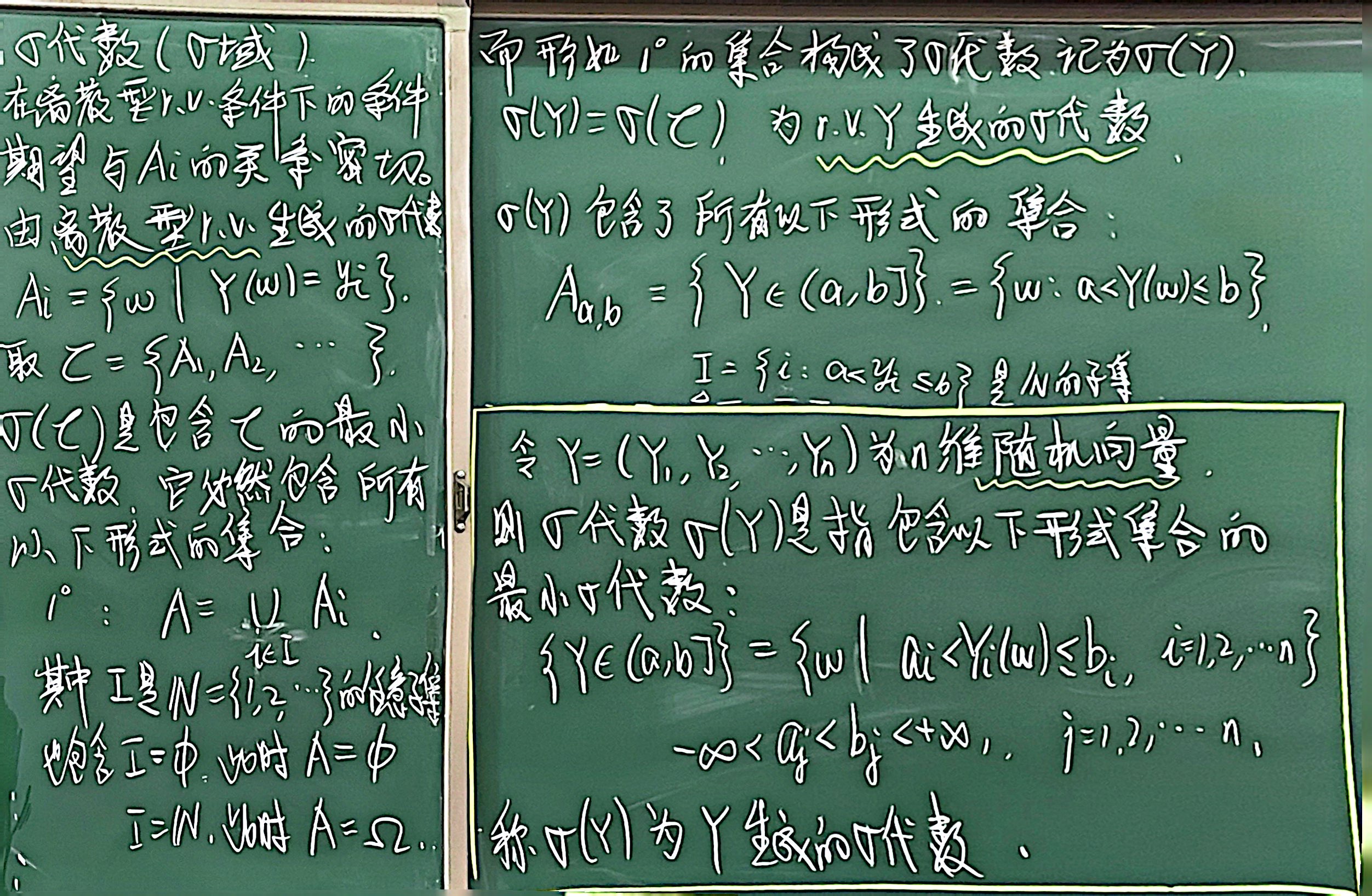

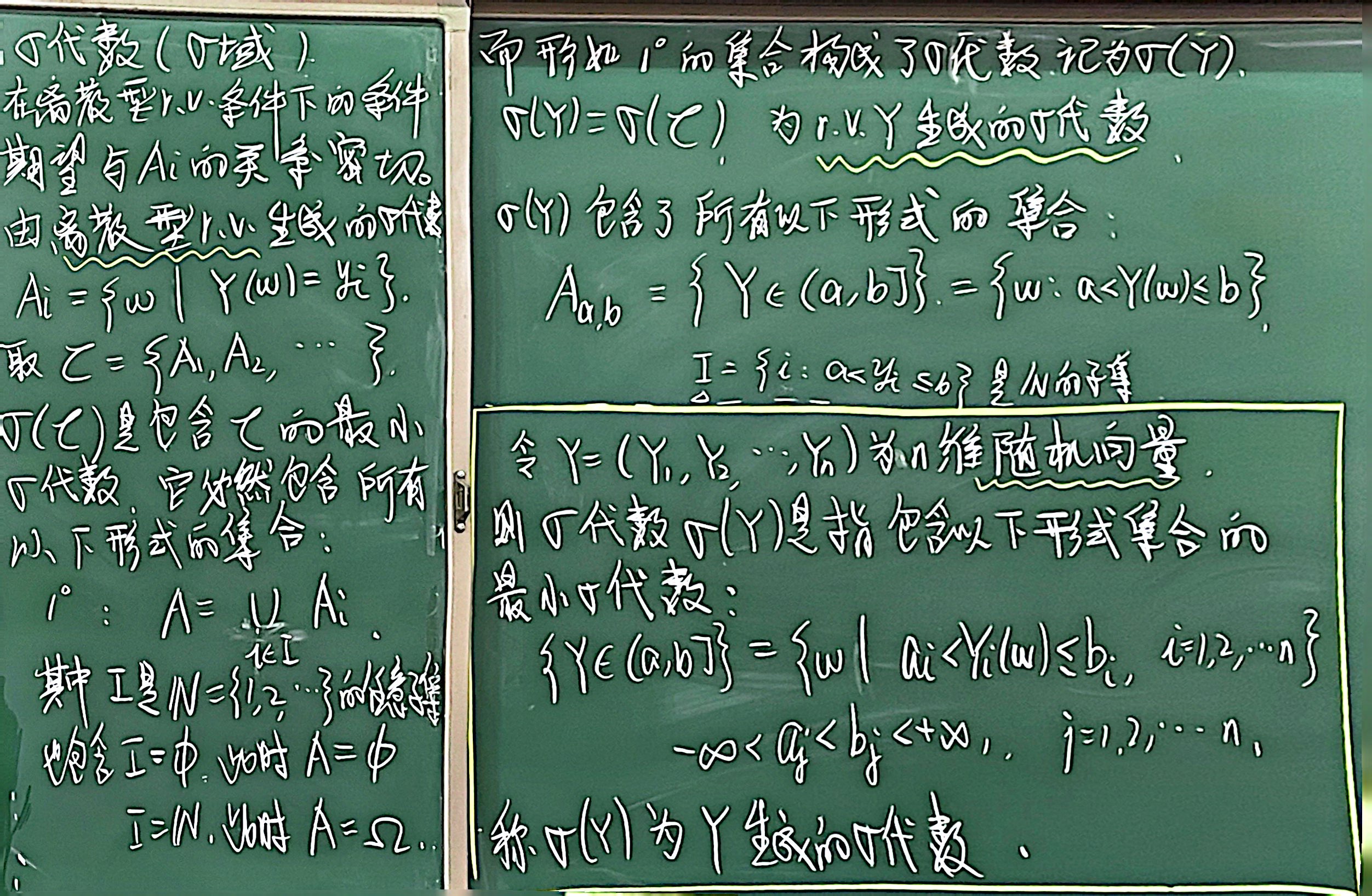

关于$\sigma $域

随机过程的$\sigma $域

对于随机过程Y={Yt,t∈T,ω∈Ω},记σ(Y)为包含以下集合的最小代数{ω:样本轨道(Yt(ω),t∈T)属于C},其中C是由T上的函数组成的任意一个恰当的集合,则称σ(Y)为由Y生成的σ代数。

一般条件期望

对于给定的σ域F,如果随机变量Z满足如下条件:

1、Z中的信息不比F中的信息多,即:σ(Z)⊂F;

2、对任意的A ∈F,有:

E(XIA)=E(ZIA)

则称随机变量Z为X在给定的σ域F下的条件期望,记为 Z=E(X∣F)

可以认为:条件期望E(X∣F)是对原来的随机变量X的简略的概况。

条件期望的性质(运算法则)

法则1:线性性质

E([C1X1+C2X2]∣F)=C1E(X1∣F)+C2E(X2∣F)

法则2:

E(X)=E(E(X∣F))

法则3:

如果X与σ域F是相互独立的,那么:E(X∣F)=E(X)

特别地,如果X与Y是相互独立的,那么:E(X∣Y)=E(X)

独立的理解:在已经知道了F的情况下,仍然不能得到关于X的更多的信息。

法则4:

如果由随机变量X生成的 σ 域 σ(X) 包含在 F 中(即 X 关于 F 可测),那么:

E(X∣F)=X

特别地,若X是Y的函数,意味着 σ(X)⊂σ(Y),则有:E(X∣Y)=X

这意味着F的信息可以提供关于X的所有信息,故可将X视为非随机来处理。

法则5:

如果由随机变量X生成的 σ 域 σ(X) 包含在 F 中(即 X 关于 F 可测),那么对任意随机变量G,有:

E(XG∣F)=XE(G∣F)

若X是Y的函数,则:E(XG∣Y)=XE(G∣Y)

法则6: 塔型法则

如果F和F′是两个σ域,满足F⊂F′,则有:

E(X∣F)=E(E(X∣F′)∣F)E(X∣F)=E(E(X∣F)∣F′)

法则7: 独立性引理

若X与F独立,Y关于F可测,则:

E(h(X,Y)∣F)=E(h(X,y))∣y=Y

条件期望的投影性质

设F是一个σ域,L2(F)是由Ω上满足如下性质的随机变量Z构成的集合:

- Z具有有限二阶距:E(Z2)<+∞

- Z携带的信息包含在F中:σ(Z)⊂F,如果F=σ(Y),则意味着Z是Y的函数。

投影性质:

设X是随机变量,满足E(X2)<+∞,则条件期望E(X∣F)是L2(F)中在均方意义下最接近X的随机变量,即:

E(X−E(X∣F))2=minZ∈L2(F)E(X−Z)2

也可以理解为E(X∣F)是在给定F下对X最好的预测。